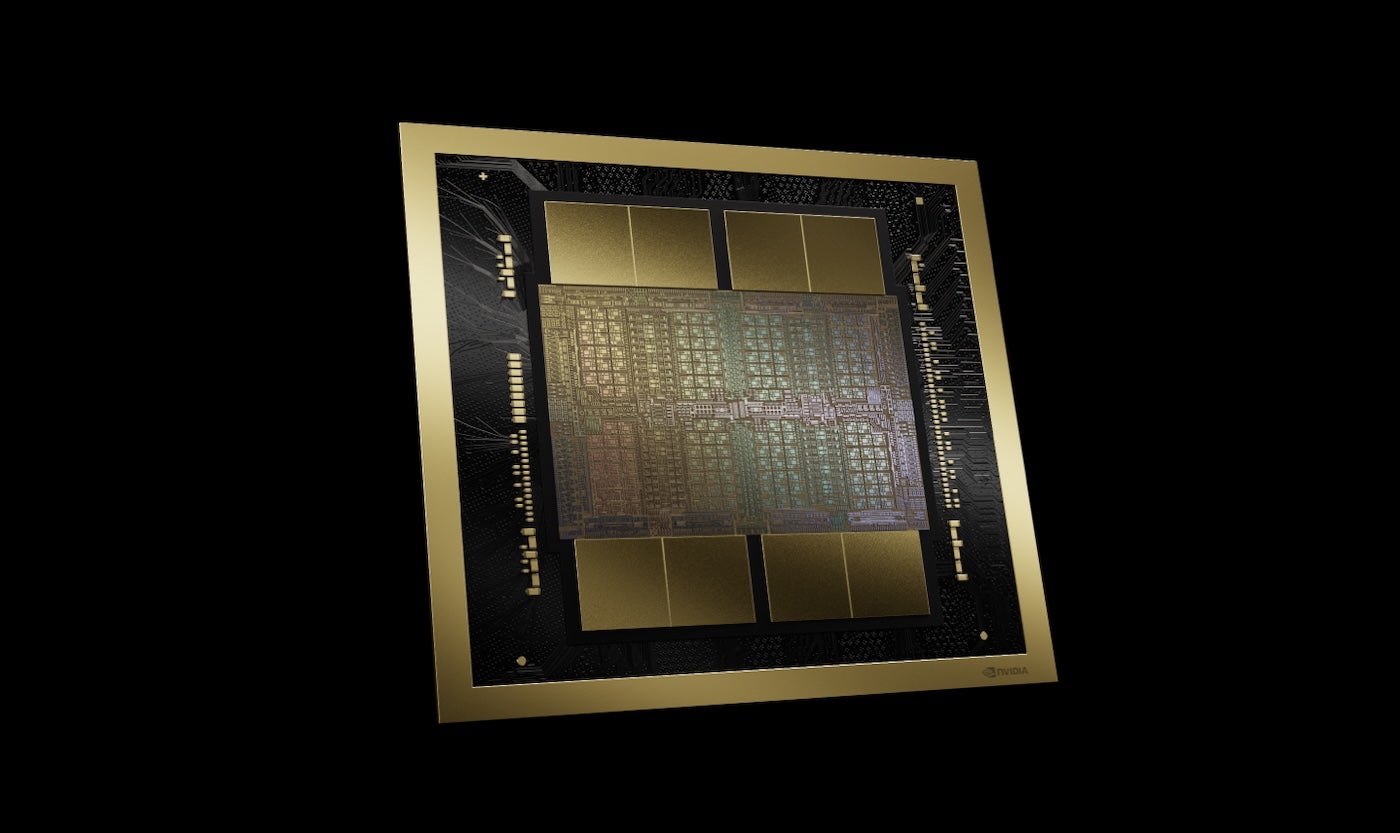

En el discurso de apertura de la conferencia NVIDIA GTC el 18 de marzo en San José, California, el CEO de NVIDIA, Jensen Huang, anunció que la última plataforma GPU de NVIDIA, Blackwell (Figura A), será adoptada por empresas como AWS, Microsoft y Google para la inteligencia artificial generativa y otras tareas informáticas modernas.

Figura A

Los productos basados en Blackwell estarán disponibles en el mercado de los socios de NVIDIA en todo el mundo para finales de 2024. Huang mencionó que Blackwell permitirá una amplia gama de tecnologías y servicios adicionales de NVIDIA y sus socios, haciendo referencia a la inteligencia artificial generativa como solo una de las muchas aplicaciones de computación acelerada.

"Cuando aceleras, tu infraestructura son las GPU CUDA", declaró Huang, refiriéndose a CUDA, la plataforma informática paralela y el modelo de programación de NVIDIA. "Y cuando eso sucede, es la misma infraestructura para la inteligencia artificial generativa".

Blackwell permite la inferencia y el entrenamiento de grandes modelos de lenguaje

La plataforma GPU Blackwell cuenta con dos matrices conectadas por una interconexión de chip a chip de 10 terabytes por segundo, lo que permite que cada lado funcione como si "las dos matrices pensaran que es un solo chip", explicó Huang. Con 208 mil millones de transistores y fabricada utilizando el proceso TSMC 4NP de 208 mil millones de NVIDIA, Blackwell ofrece un ancho de banda de memoria de 8 TB/S y un rendimiento de inteligencia artificial de 20 petaFLOPS.

Para las empresas, esto significa que Blackwell tiene la capacidad de llevar a cabo el entrenamiento e inferencia para modelos de inteligencia artificial escalando hasta 10 billones de parámetros, según NVIDIA.

Blackwell se beneficia de las siguientes tecnologías:

- La segunda generación de TensorRT-LLM y NeMo Megatron, ambos de NVIDIA.

- Marcos para duplicar el tamaño de cálculo y modelo en comparación con el motor transformador de primera generación.

- Computación confidencial con protocolos de cifrado de interfaz nativos para privacidad y seguridad.

- Un motor de descompresión dedicado para acelerar consultas de bases de datos en análisis de datos y ciencia de datos.

En relación con la seguridad, Huang mencionó que el motor de confiabilidad "realiza una autoprueba, una prueba dentro del sistema, de cada bit de memoria en el chip Blackwell y de toda la memoria conectada a él. Es como si enviáramos el chip Blackwell con su propio probador".

Los productos basados en Blackwell estarán disponibles a través de proveedores de servicios en la nube asociados, empresas del programa socio de NVIDIA Cloud y empresas seleccionadas, incluidas nubes soberanas. soberano nubes.

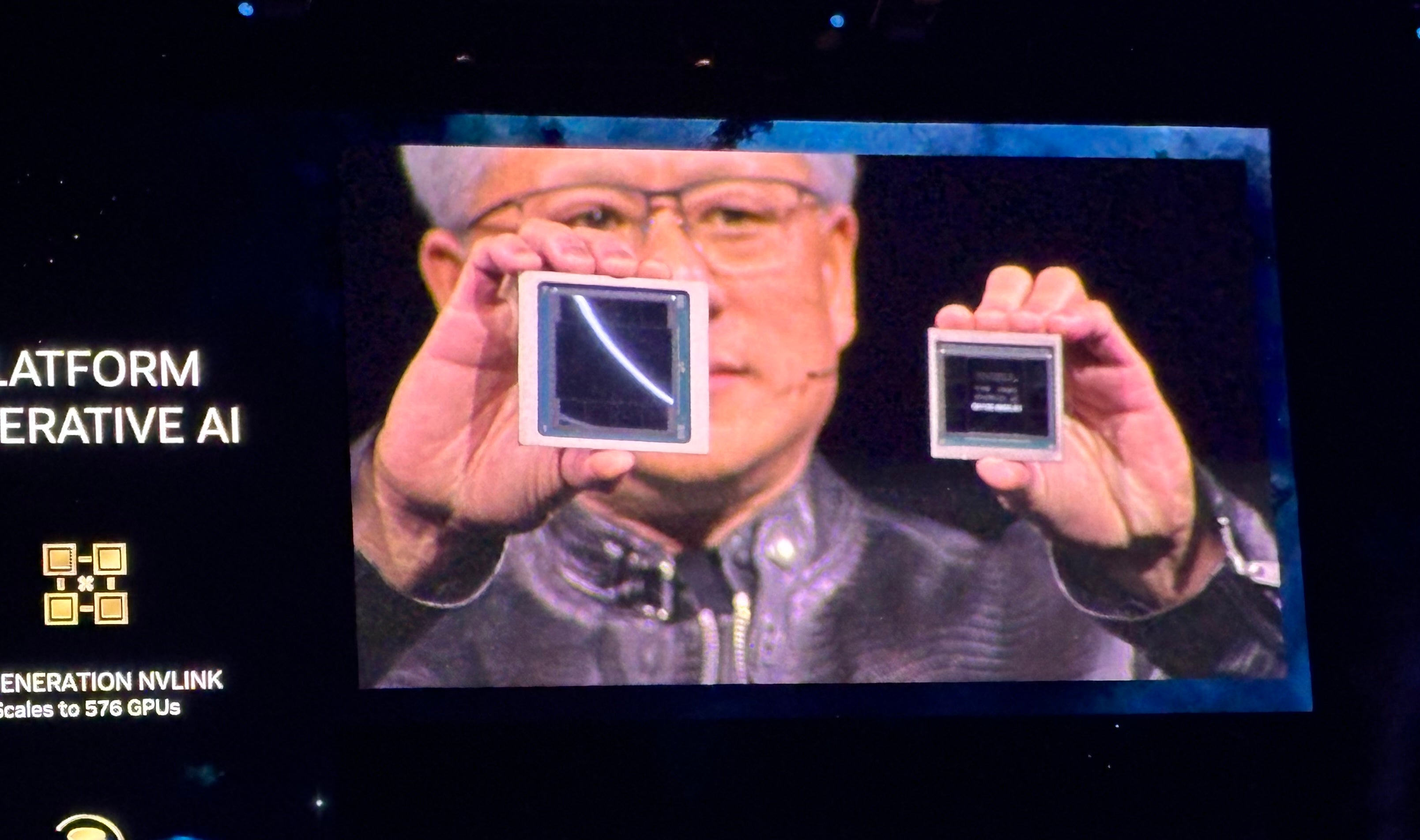

La línea de GPU Blackwell sigue la línea de GPU Grace Hopper, presentada en 2022 (Figura B). Según NVIDIA, Blackwell ejecutará inteligencia artificial generativa en tiempo real en LLM de billones de parámetros a un costo 25 veces menor y un consumo energético más bajo que la línea Hopper.

Figura B

NVIDIA GB200 Grace Blackwell Superchip conecta múltiples GPU Blackwell

Junto con las GPU Blackwell, la compañía presentó el Superchip NVIDIA GB200 Grace Blackwell, que conecta dos GPU NVIDIA B200 Tensor Core a la CPU NVIDIA Grace, ofreciendo una nueva plataforma combinada para la inferencia LLM. El Superchip NVIDIA GB200 Grace Blackwell se puede unir a las plataformas Ethernet NVIDIA Quantum-X800 InfiniBand y Spectrum-X800 recientemente.

Anunciado por la compañía para velocidades de hasta 800 GB/s.

El GB200 estará disponible en NVIDIA DGX Cloud y también a través de instancias en AWS, Google Cloud y Oracle Cloud Infrastructure hacia finales de este año.

El nuevo diseño del servidor se enfoca en modelos de IA de trillones de parámetros

El GB200 forma parte del recientemente presentado GB200 NVL72, un diseño de servidor a escala de rack que incluye 36 CPUs Grace y 72 GPUs Blackwell para un rendimiento de IA de 1.8 exaFLOP. NVIDIA visualiza posibles casos de uso para modelos de lenguaje masivos de trillones de parámetros, como memoria persistente de conversaciones, aplicaciones científicas complejas y modelos multimodales.

El GB200 NVL72 integra la quinta generación de conectores NVLink (5000 cables NVLink) y el superchip GB200 Grace Blackwell para ofrecer una enorme capacidad computacional que Huang describe como "un sistema de IA exoflops en un único rack".

"Eso supera el ancho de banda promedio de Internet… prácticamente podríamos enviar todo a todo el mundo", comentó Huang.

"Nuestro objetivo es seguir reduciendo continuamente el costo y el consumo energético (están directamente relacionados) de la computación", afirmó Huang.

Se necesitan dos litros de agua por segundo para refrigerar el GB200 NVL72.

La próxima generación de NVLink ofrece una arquitectura acelerada de centros de datos

La quinta generación de NVLink proporciona un rendimiento bidireccional de 1.8 TB/s por comunicación entre GPU, admitiendo hasta 576 GPU. Esta versión de NVLink está diseñada para utilizarse en los modelos de lenguaje más potentes y complejos disponibles en la actualidad.

"En el futuro, los centros de datos se verán como fábricas de inteligencia artificial", afirmó Huang.

Presentación de los microservicios de inferencia de NVIDIA

Otro elemento clave de la potencial "fábrica de IA" son los Microservicios de Inferencia de NVIDIA, o NIM, que Huang describió como "una nueva forma de ofrecer y empaquetar software".

NIM de NVIDIA son microservicios que incluyen las API, código especializado de dominio, motores de inferencia optimizados y entornos de ejecución empresarial necesarios para implementar IA generativa. Estos microservicios nativos de la nube pueden escalarse según la cantidad de GPU que requiera el cliente y ejecutarse tanto en la nube como en sus propios centros de datos. Los NIM permiten a los desarrolladores utilizar API, NVIDIA CUDA y Kubernetes en un único paquete.

VER: Python sigue siendo el lenguaje de programación más popular según el Índice TIOBE. (República Tecnológica)

Los NIM aprovechan la inteligencia artificial para crear más IA, facilitando tareas pesadas como inferencia y entrenamiento necesarios para desarrollar chatbots. A través de bibliotecas CUDA especializadas por dominio, es posible personalizar los NIM para sectores muy específicos como la medicina.

En lugar de escribir código para programar IA, Huang mencionó que los desarrolladores pueden "reunir un equipo de IA" para trabajar dentro del NIM.

"Queremos desarrollar chatbots (copilotos de IA) que colaboren con nuestros diseñadores", agregó Huang.

Los NIM estarán disponibles a partir del 18 de marzo. Los desarrolladores podrán probar los NIM de forma gratuita y ejecutarlos mediante una suscripción a NVIDIA AI Enterprise 5.0. Los NIM se integrarán en Amazon SageMaker, Google Kubernetes Engine y Microsoft Azure AI, y serán compatibles con los marcos de IA Deepset, LangChain y LlamaIndex.

Nuevas herramientas lanzadas para NVIDIA AI Enterprise en la versión 5.0

NVIDIA ha presentado la versión 5.0 de AI Enterprise, su plataforma destinada a ayudar a las organizaciones en la implementación de productos de IA generativa para sus clientes. En AI Enterprise 5.0 se incluyen las siguientes novedades:

- NIM.

- Microservicios CUDA-X para diversos casos de uso de IA acelerada por GPU.

- AI Workbench, un conjunto de herramientas para desarrolladores.

- Soporte para la plataforma Red Hat OpenStack.

- Soporte extendido para las nuevas GPU NVIDIA, hardware de red y software de virtualización.

El operador de modelo de lenguaje ampliado de recuperación de NVIDIA ahora está en fase de acceso temprano para AI Enterprise 5.0.

AI Enterprise 5.0 está disponible a través de Cisco, Dell Technologies, HP, HPE, Lenovo, Supermicro y otros proveedores.

Otros importantes anuncios de NVIDIA en GTC 2024

Huang reveló una amplia gama de nuevos productos y servicios en computación acelerada e inteligencia artificial generativa durante la conferencia magistral de NVIDIA GTC 2024.

NVIDIA dio a conocer cuPQC, una biblioteca utilizada para acelerar la criptografía poscuántica. Los desarrolladores interesados en la criptografía poscuántica pueden comunicarse con NVIDIA para obtener información sobre su disponibilidad.

La serie X800 de switches de red de NVIDIA impulsa la infraestructura de IA. En este sentido, la serie X800 incluye los switches Ethernet NVIDIA Quantum-X800 InfiniBand o NVIDIA Spectrum-X800, el switch NVIDIA Quantum Q3400 y el NVIDIA ConnectXR-8 SuperNIC. Los switches X800 estarán disponibles en 2025.

Entre las principales asociaciones detalladas durante la presentación de NVIDIA se encuentran:

- La plataforma de IA integral de NVIDIA estará presente en Enterprise AI de Oracle a partir del 18 de marzo.

- AWS ofrecerá acceso a instancias Amazon EC2 basadas en GPU NVIDIA Grace Blackwell y seguridad Blackwell en NVIDIA DGX Cloud.

- NVIDIA potenciará Google Cloud con la plataforma computacional NVIDIA Grace Blackwell AI y el servicio NVIDIA DGX Cloud, que llegarán a Google Cloud. Aunque Google aún no ha confirmado una fecha de disponibilidad, es probable que sea a finales de 2024. Además, la plataforma DGX Cloud con tecnología NVIDIA H100 estará disponible en Google Cloud de manera general a partir del 18 de marzo.

- Oracle empleará NVIDIA Grace Blackwell en su OCI Supercluster, OCI Compute y NVIDIA DGX Cloud en Oracle Cloud Infrastructure. Está previsto que los Servicios combinados de IA soberana de Oracle y NVIDIA estén disponibles a partir del 18 de marzo.

- Microsoft adoptará el superchip NVIDIA Grace Blackwell para impulsar Azure. Se espera que esté disponible más adelante en 2024.

- Dell utilizará la infraestructura de IA y el conjunto de software de NVIDIA para desarrollar Dell AI Factory, una solución empresarial de extremo a extremo en IA disponible a partir del 18 de marzo a través de canales tradicionales y Dell APEX. En una fecha futura no revelada, Dell utilizará el superchip NVIDIA Grace Blackwell como base para una arquitectura de refrigeración líquida, de alta densidad y en escala de rack. Este superchip será compatible con los servidores PowerEdge de Dell.

- SAP integrará capacidades de generación avanzada de recuperación de NVIDIA en su copiloto Joule. Además, SAP empleará los NIM de NVIDIA y otros servicios conjuntos.

"Toda la industria se está preparando para Blackwell", mencionó Huang.

Competidores de los chips de IA de NVIDIA

NVIDIA compite principalmente con AMD e Intel en el ámbito de la provisión de IA empresarial. Qualcomm, SambaNova, Groq y diversos proveedores de servicios en la nube también incursionan en el mismo espacio en términos de inferencia y entrenamiento de IA generativa.

AWS cuenta con sus propias plataformas de inferencia y entrenamiento: Inferentia y Trainium. Además de colaborar con NVIDIA en una amplia gama de productos, Microsoft dispone de su propio chip de inferencia y entrenamiento de IA: el Maia 100 AI Accelerator en Azure.

Descargo de responsabilidad: NVIDIA costeó mi transporte aéreo, alojamiento y algunas comidas para el evento de NVIDIA GTC celebrado del 18 al 21 de marzo en San José, California.