Esta publicación de blog se centra en nuevas funciones y mejoras. Para obtener una lista completa, incluidas las correcciones de errores, consulte la Notas de lanzamiento.

Esta publicación de blog se centra en nuevas funciones y mejoras. Para obtener una lista completa, incluidas las correcciones de errores, consulte la Notas de lanzamiento.

RAG en 4 líneas de código

RAG es una arquitectura que ofrece los datos más relevantes y contextualmente importantes a los LLM al responder preguntas. Puede utilizarse para aplicaciones como sistemas avanzados de respuesta a preguntas, sistemas de recuperación de información, chat con sus datos y más.

Se ha integrado el nuevo modelo de operador RAG-Prompter. Ahora es posible utilizar RAG-Prompter, un operador de sistema agente en el SDK de Python, para llevar a cabo tareas de RAG en solo 4 líneas de código.

Revise el siguiente video que le guiará paso a paso en la construcción de un sistema RAG en 4 líneas de código.

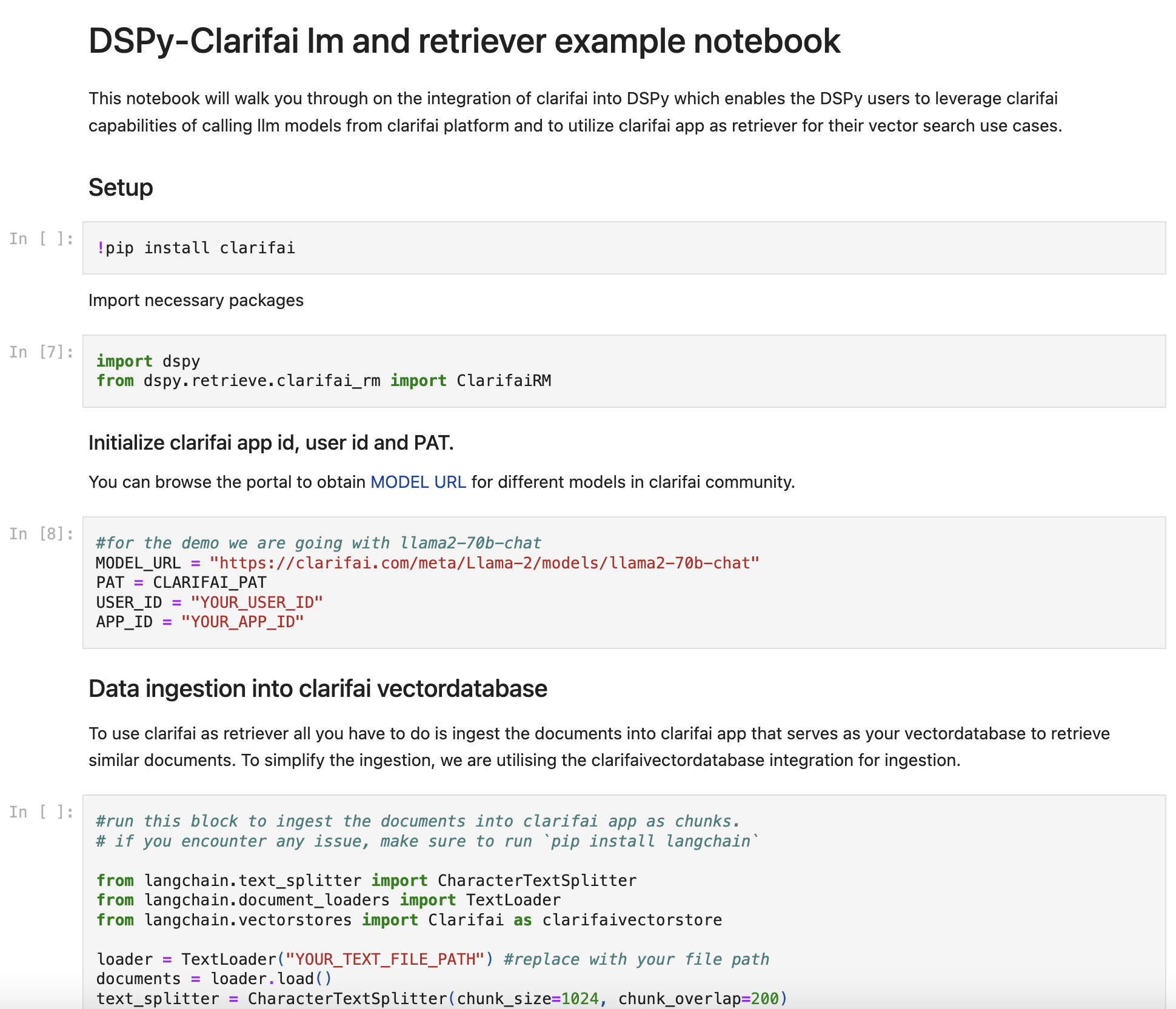

Clarifai integrado en DSPy

- DSPy es el marco para resolver tareas avanzadas con lenguaje y modelos de recuperación. Unifica técnicas para incitar y ajustar modelos de lenguaje.

Esta integración, que ahora forma parte de la versión 2.1.7 de DSPy lanzada recientemente, le ayuda a consumir los modelos LLM de Clarifai y utilizar sus aplicaciones de Clarifai como motor de búsqueda vectorial dentro de DSPy. Clarifai es el único proveedor que permite a los usuarios aprovechar múltiples modelos LLM. Puede comenzar a usar DSPy con Clarifai aquí.

Se introdujo el entrenamiento incremental de versiones de modelos.

- Ahora es posible actualizar los modelos existentes con nuevos datos sin necesidad de volver a entrenarlos desde cero. Después de entrenar una versión del modelo, se guarda automáticamente un archivo de punto de control. Puede iniciar el entrenamiento incremental desde ese punto de control de la versión previamente entrenada. Alternativamente, puede proporcionar la URL de un archivo de punto de control de un kit de herramientas de terceros compatible, como HuggingFace o MMCV.

Se introdujo la capacidad de agregar entradas a través de URL de almacenamiento en la nube.

- Ahora es posible proporcionar URL desde plataformas de almacenamiento en la nube como S3, GCP y Azure, acompañadas de las credenciales de acceso necesarias. Esta función facilita la adición de entradas a nuestra plataforma, ofreciendo una alternativa más eficiente al método convencional de utilizar PostInputs para entradas individuales.

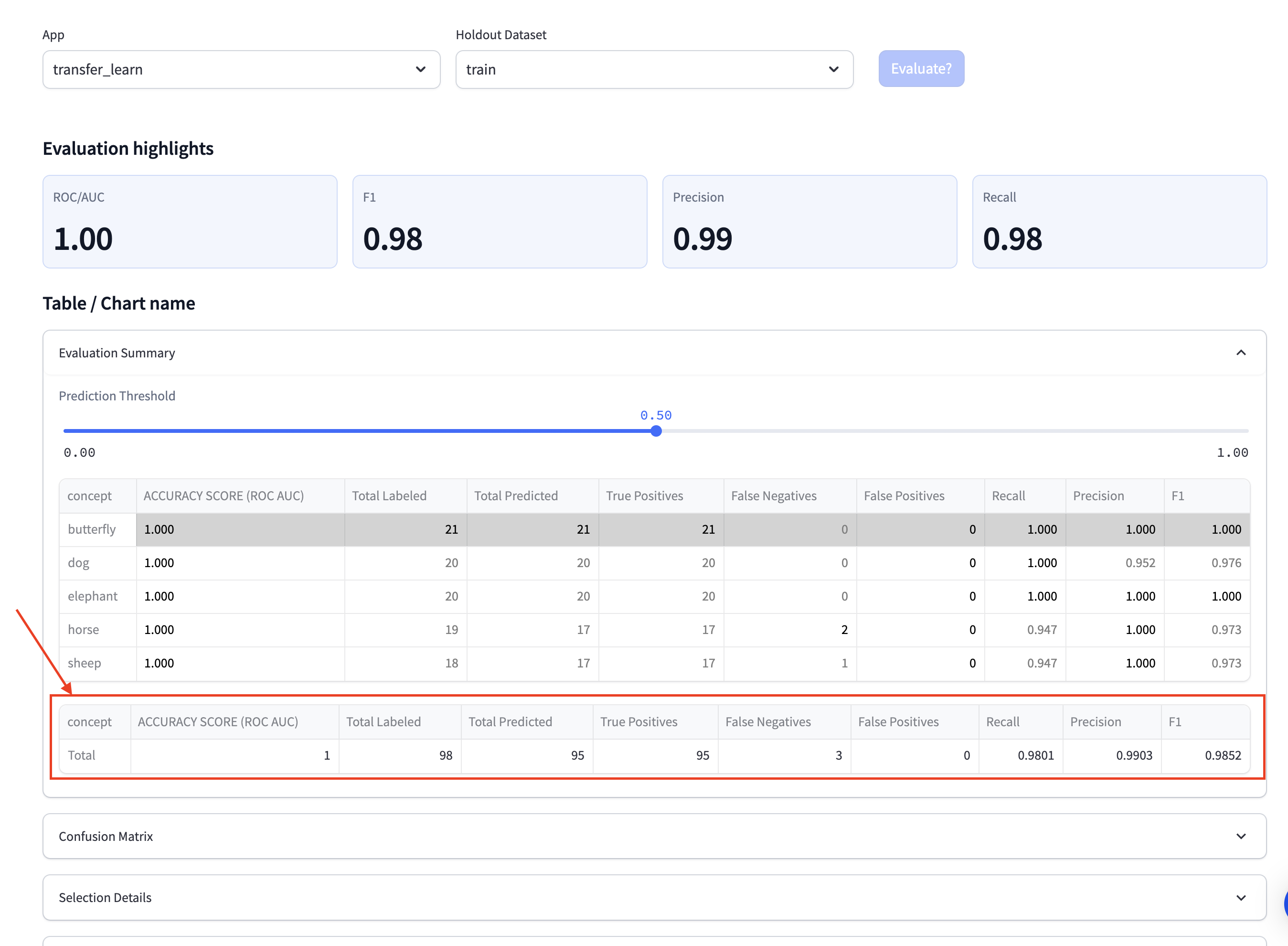

Se mejoró el proceso de evaluación de los modelos de detectores.

- Se han enriquecido las métricas mediante la introducción de campos adicionales, a saber, "Total previsto", "Verdaderos positivos", "Falsos negativos" y "Falsos positivos". Estas métricas adicionales proporcionan una evaluación más completa y detallada del rendimiento de un detector.

- Se reemplazó el multiselector utilizado anteriormente para seleccionar una Intersección sobre Unión (IoU) con un formato de botón de opción. Esto enfatiza una opción única y mutuamente excluyente para la selección de IoU.

- Se realizaron otras mejoras adicionales en UI/UX para asegurar la coherencia con el proceso de evaluación de los modelos de clasificación.

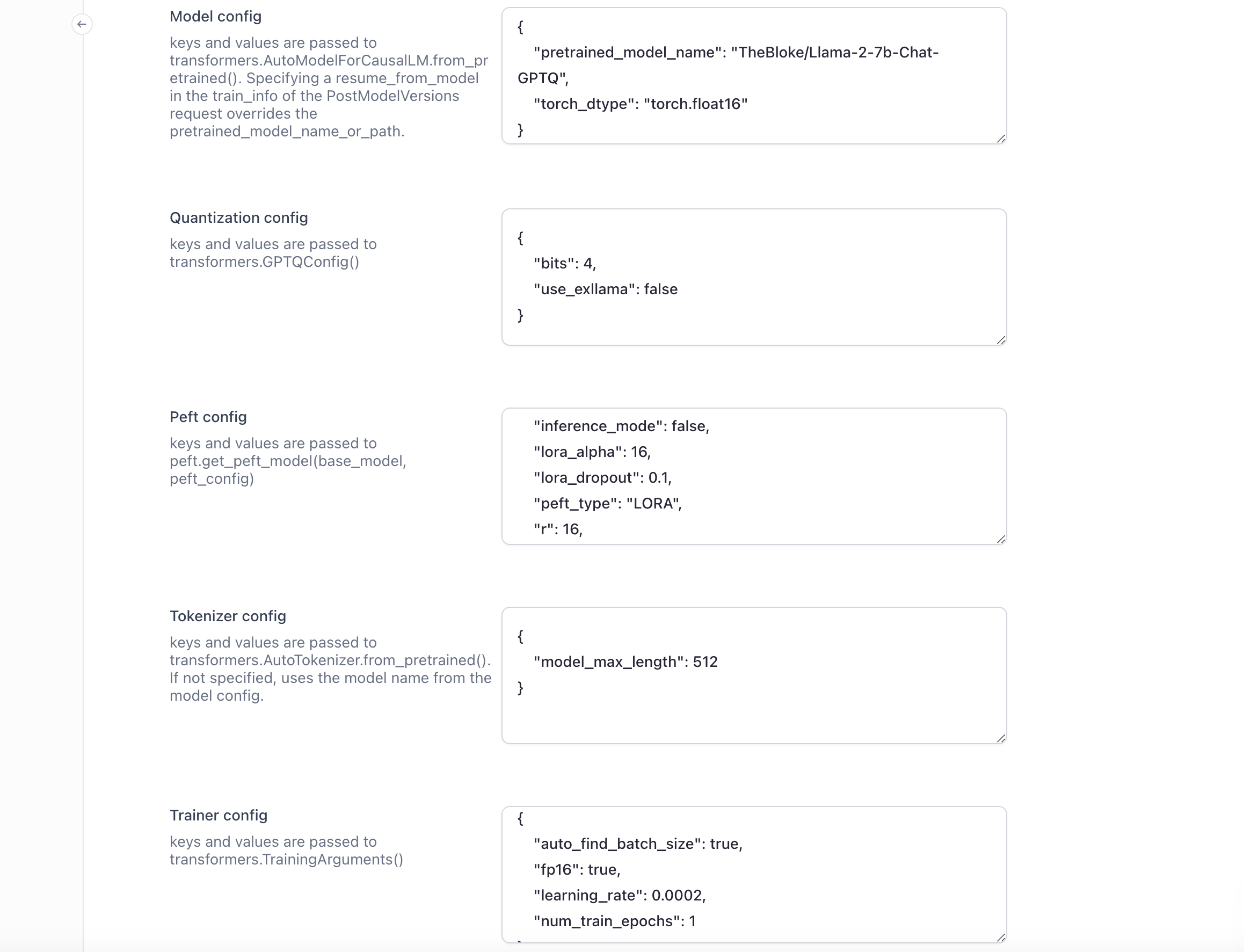

Mejoras en el ajuste de LLM

- Se introdujo soporte para carga CSV para una integración optimizada de datos.

- Se agregaron más plantillas de entrenamiento para adecuar el proceso de ajuste a varias situaciones de uso.

- Se incluyeron opciones de configuración avanzadas, como parámetros de cuantificación a través de GPTQ. Esto permite a los usuarios ajustar los modelos con mayor precisión y eficiencia.

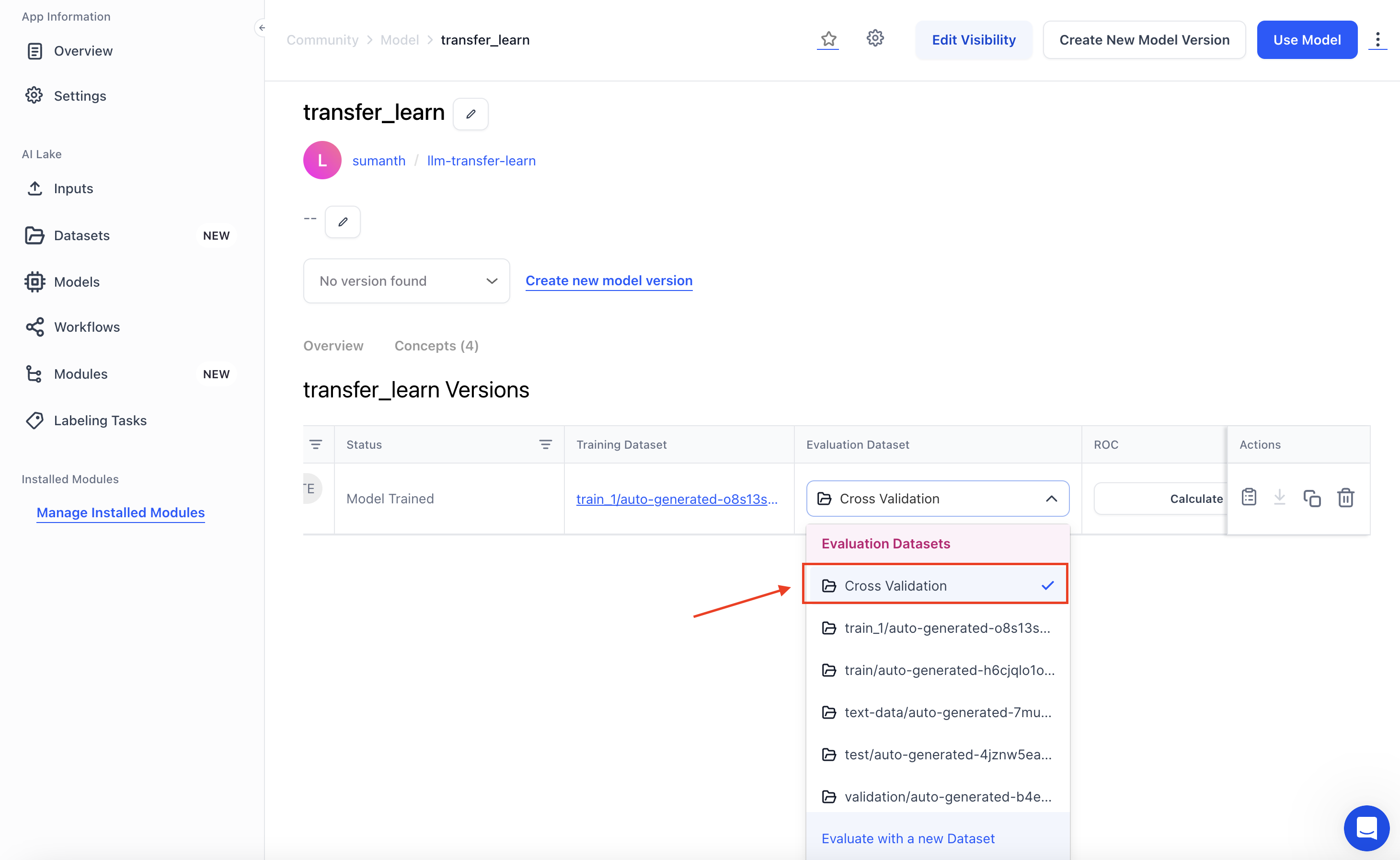

Mejoras en la tabla de versiones del Model-Viewer

- Ahora se admite la evaluación entre aplicaciones en la pestaña de versión del modelo para una experiencia más coherente con la tabla de clasificación.

- Los usuarios y colaboradores con permisos de acceso también pueden seleccionar conjuntos de datos o versiones de conjuntos de datos de las aplicaciones de la organización, lo que garantiza una evaluación integral en varios contextos.

- Esta mejora permite a los usuarios ver datos de entrenamiento y evaluación en diferentes versiones de modelos en una ubicación centralizada, lo que mejora toda la experiencia de seguimiento de versiones.

Mejoras en la gestión de anotaciones de modelos y activos asociados

- Antes, la eliminación de una anotación de modelo no afectaba a los recursos correspondientes. Ahora, al eliminar una anotación de modelo, los recursos asociados se marcan como eliminados simultáneamente. Esto asegura una eliminación integral, evitando activos persistentes o huérfanos.

Publicación de varios modelos nuevos e innovadores

- Se lanzó fi-2, un modelo de lenguaje grande (LLM) de 2.700 millones de parámetros alojado en Clarifai, que destaca en tareas de control de calidad, chat y código. Este modelo se enfoca en datos de entrenamiento de alta calidad y demuestra un comportamiento mejorado en cuanto a toxicidad y sesgo.

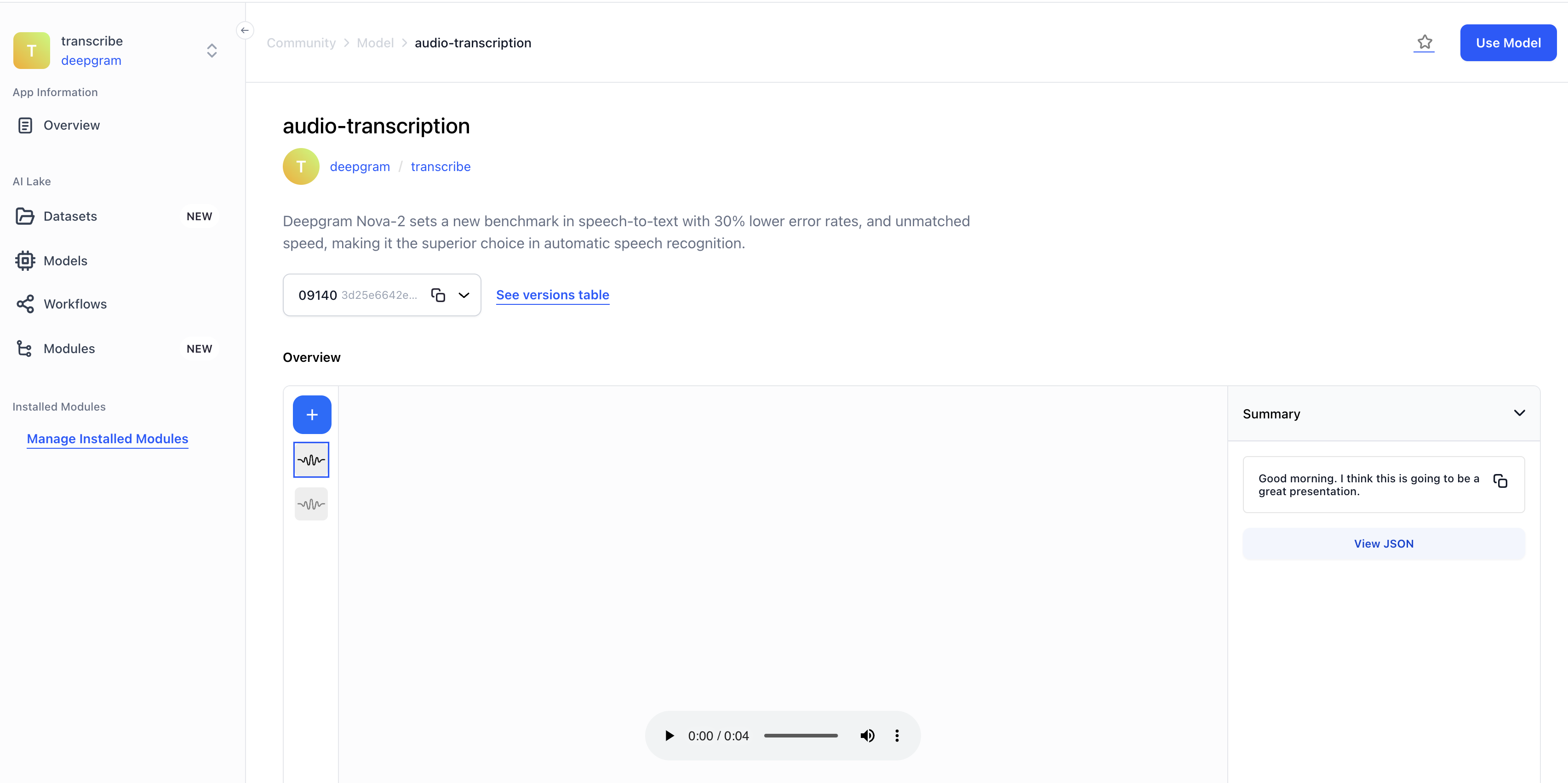

- Se presentó Deepgrama Nova-2, que establece un nuevo estándar en la conversión de voz a texto con tasas de error un 30 % más bajas y una velocidad inigualable, convirtiéndola en la mejor opción en reconocimiento automático de voz.

- Envuelto Resumen de audio de Deepgram. Ofrece resúmenes eficientes y precisos de contenido de audio, automatiza notas de llamadas, resúmenes de reuniones y vistas previas de podcasts con capacidades de transcripción superiores.

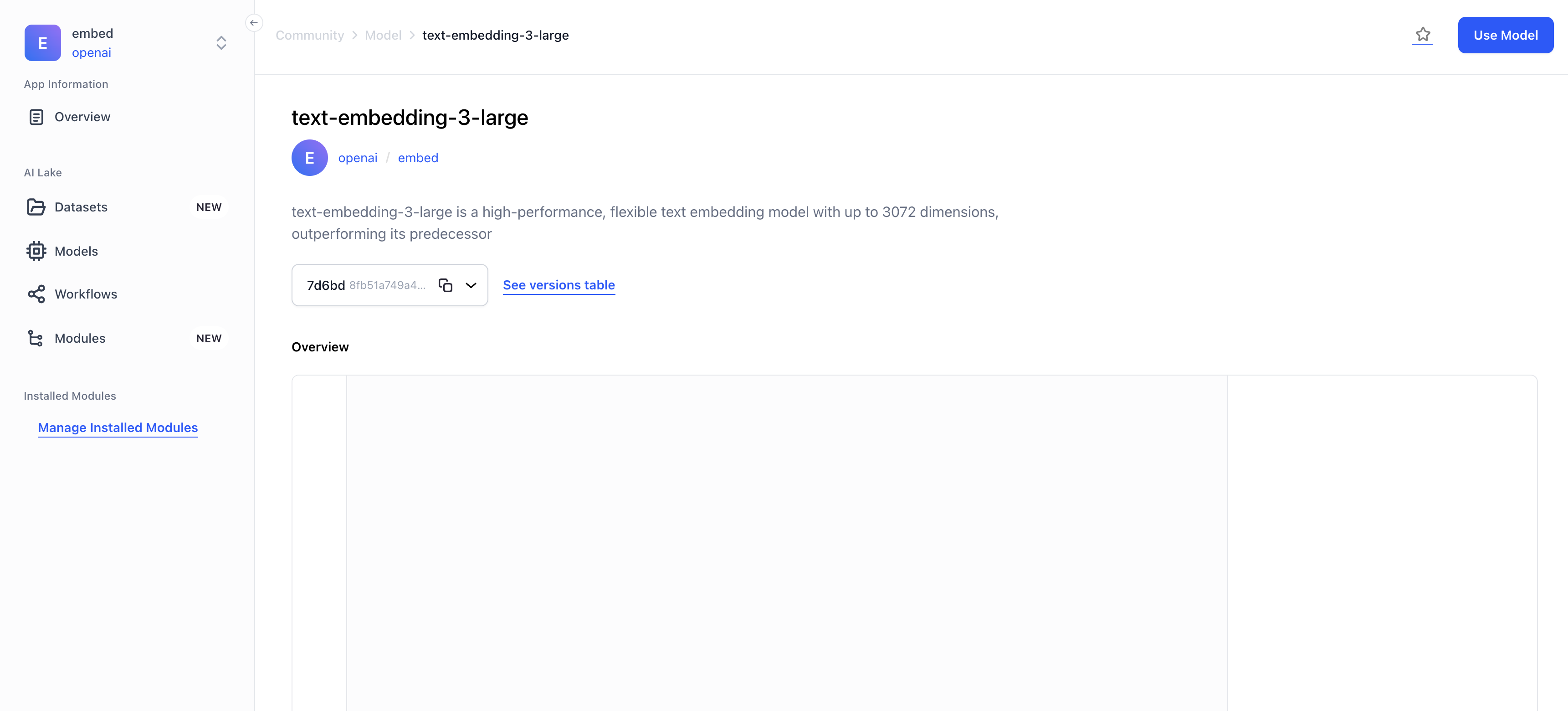

- Envuelto Incrustación de texto-3-grandeun modelo de incrustación de texto flexible y de alto rendimiento con hasta 3072 dimensiones, superando a su predecesor.

- Envuelto Incrustación de texto-3-Pequeñoun modelo altamente eficiente y flexible con rendimiento mejorado con respecto a su predecesor, Text-Embedding-ADA-002, en diversas tareas de procesamiento del lenguaje natural.

- Envuelto CodeLlama-70b-Instrucciónun modelo de IA de última generación especializado en generación y comprensión de código basado en instrucciones en lenguaje natural.

- Envuelto CódigoLlama-70b-Pythonun modelo de IA de última generación especializado en la generación y comprensión de código Python, que destaca por su precisión y eficiencia.

Se mejoró la versión móvil del flujo de incorporación.

- Se actualizó la modalidad de visita guiada "crear una aplicación" para plataformas móviles.

- Se realizaron otras mejoras, como la actualización del modo "Agregar un modelo" y el modo "Buscar un modelo previamente entrenado" para plataformas móviles.

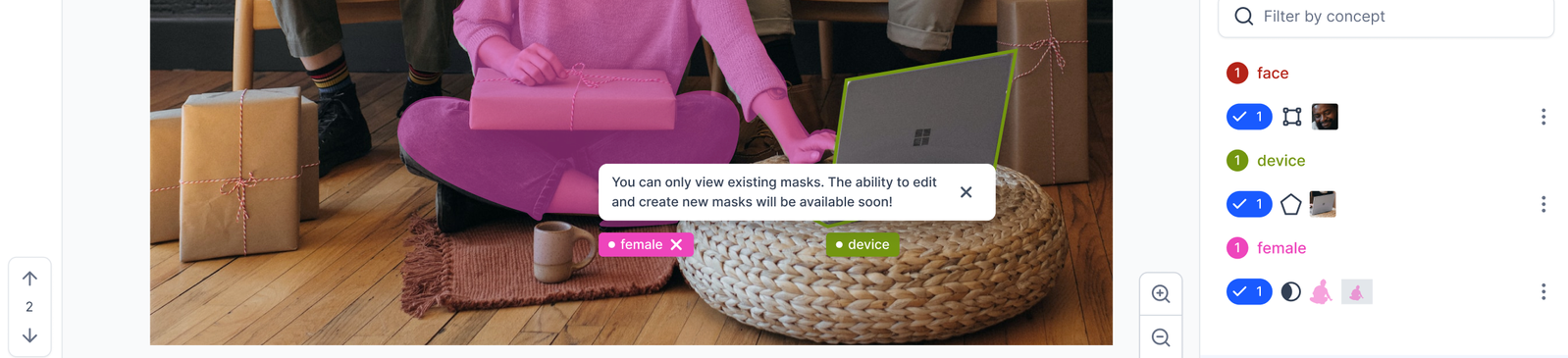

Se agregó la capacidad de revisar mínimamente las anotaciones de máscaras de imágenes existentes en el Visor de entrada.

- Puede ver las anotaciones de su máscara de imagen cargadas a través de la API.

- Puede eliminar una anotación de máscara de imagen completa en una entrada

- Puede ver los elementos de anotación de máscara que se muestran en la barra lateral del Visor de entrada.

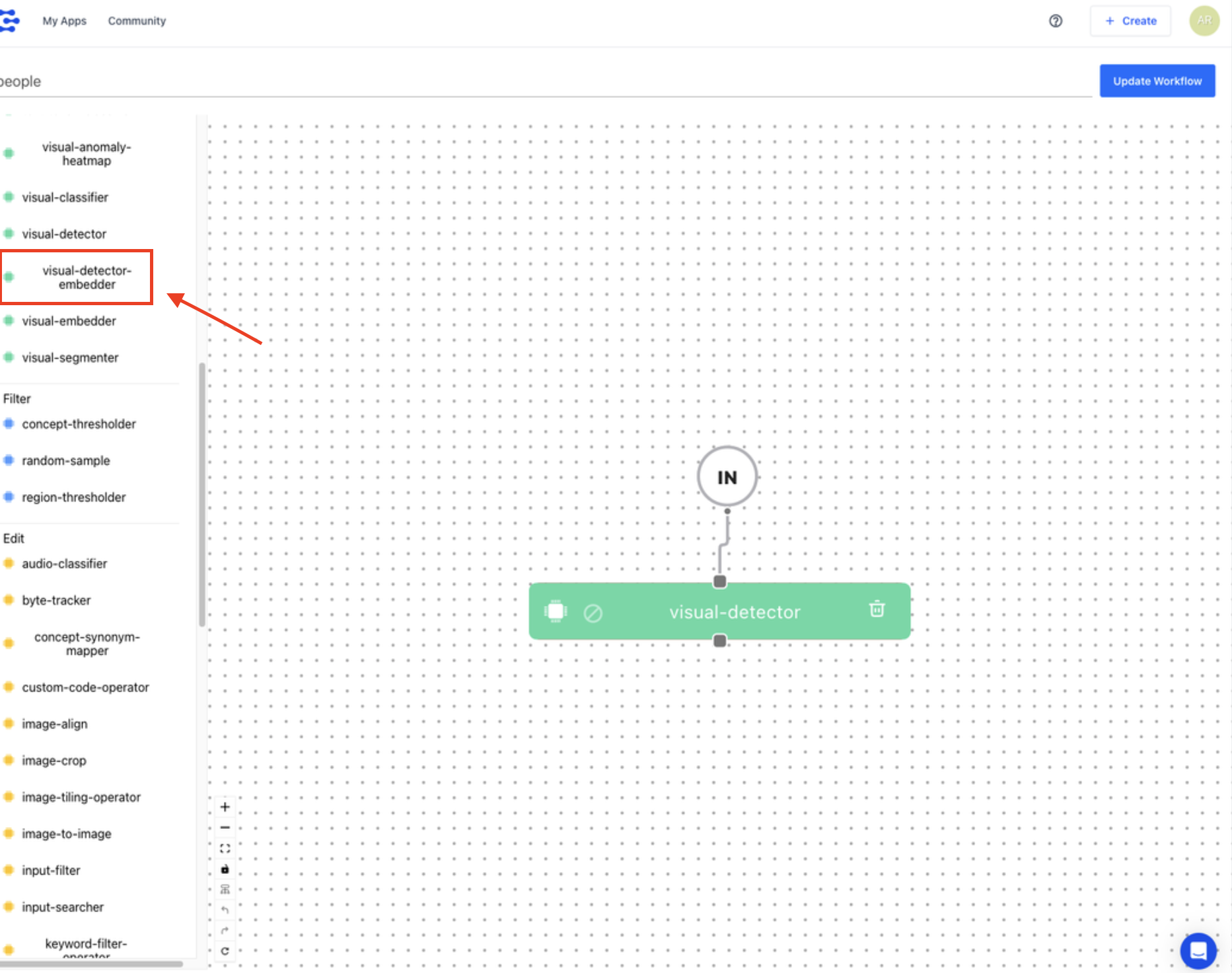

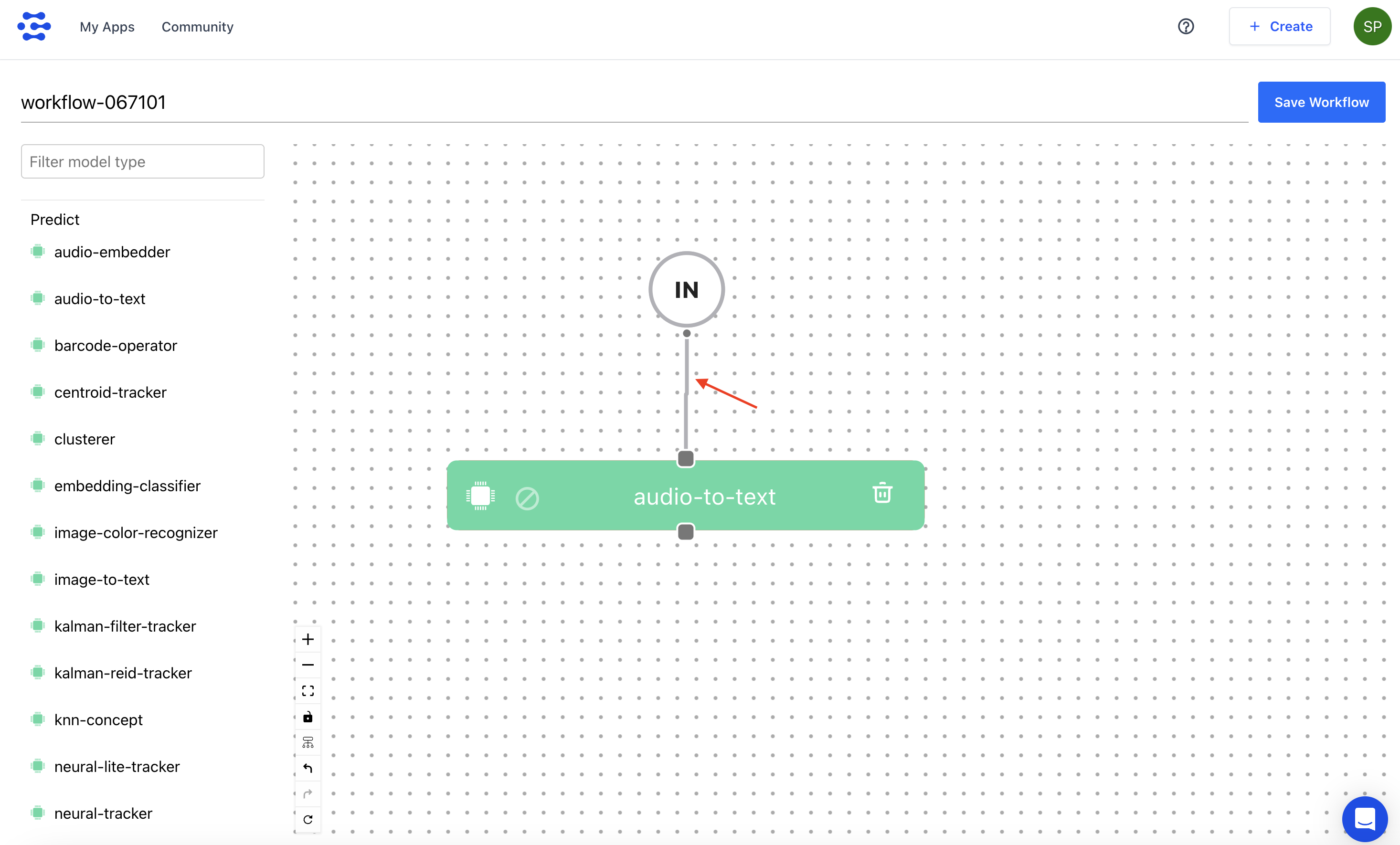

Se realizaron mejoras menores en la interfaz de usuario del generador de flujo de trabajo.

- Se corrigió la discrepancia de alineación en algunos modelos del lado izquierdo para garantizar una alineación izquierda uniforme.

- Se incluyó un botón adicional para cerrar o cancelar con el fin de mejorar la interacción y la comprensión del usuario.

- Se garantizó que los usuarios puedan ajustar fácilmente la línea que conecta dos nodos.

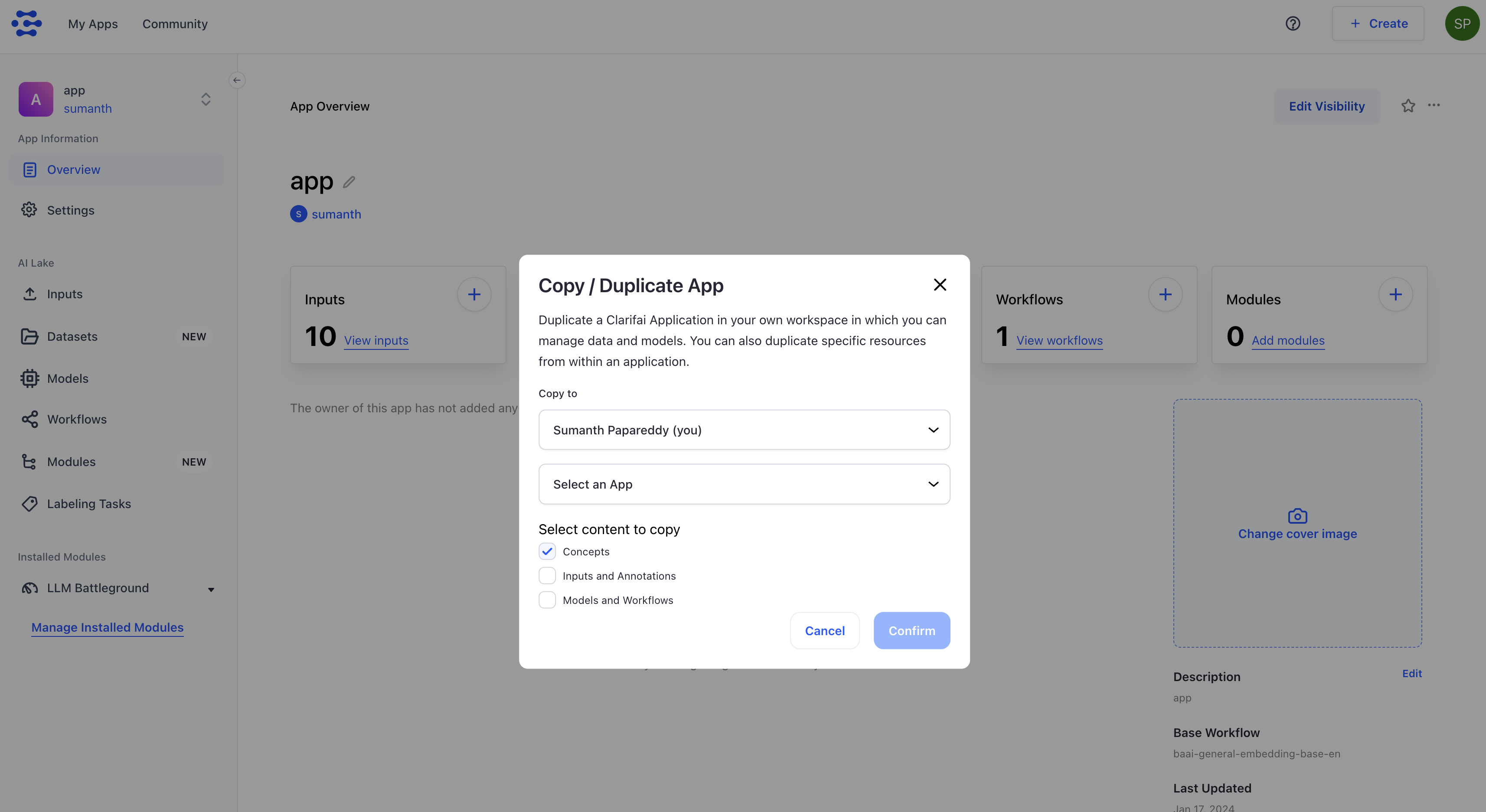

Se añadió la funcionalidad de copiar una aplicación a una organización.

- Anteriormente, en el modal de Copiar/duplicar aplicación , el menú desplegable para seleccionar usuarios no incluía la opción para organizaciones. Ahora, al copiar o duplicar una aplicación, puedes seleccionar directamente una organización desde la lista desplegable de destinos potenciales.

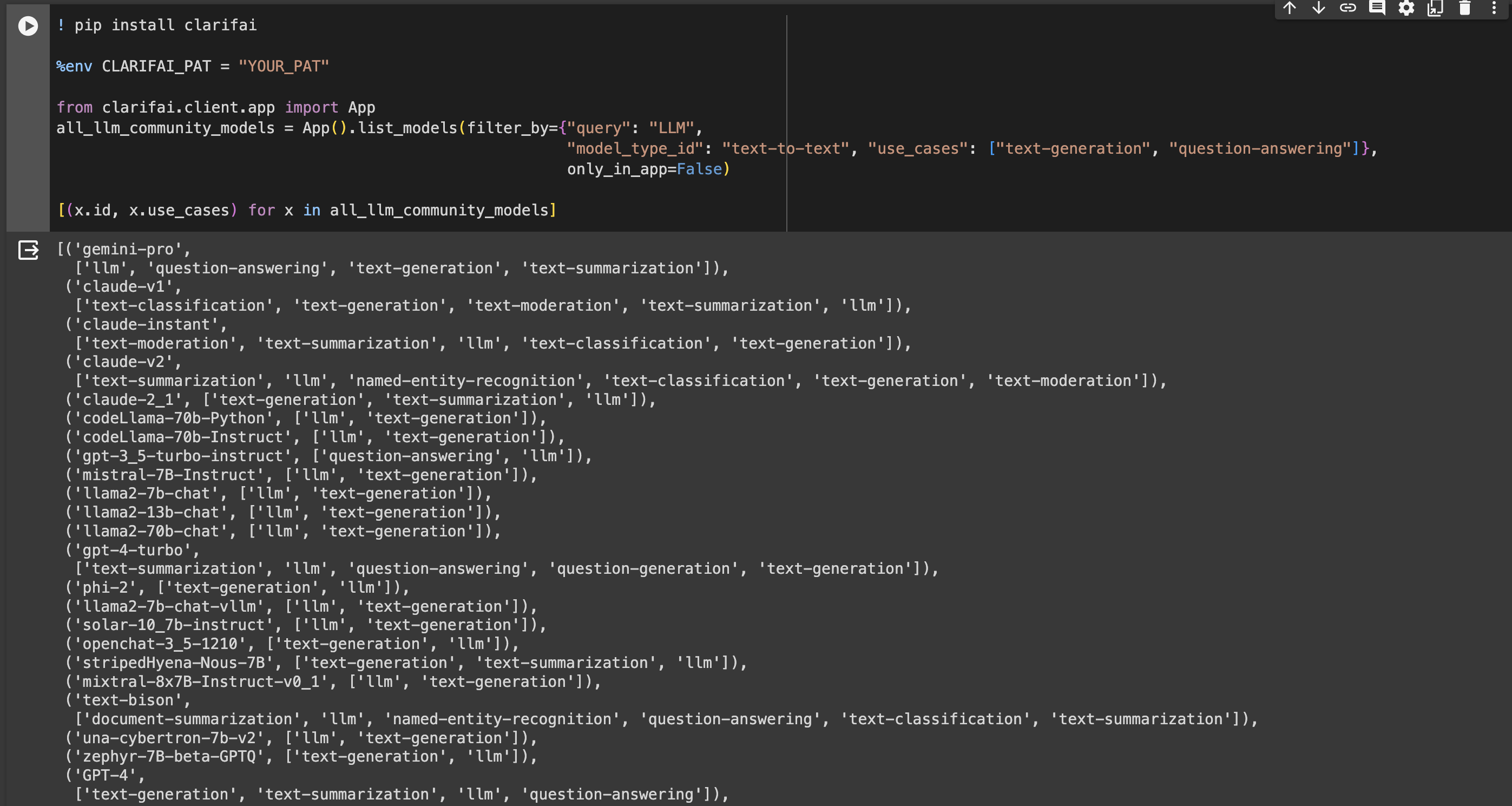

Se mejoró la funcionalidad de búsqueda en el campo use_cases.

- Antes, el campo

use_casesen la función ListModels estaba configurado para realizar una búsqueda AND, a diferencia de otros campos comoinput_fieldsyoutput_fields. Mejoramos el atributouse_casespara funcionar con lógica OR, alineándolo con los demás campos. Este ajuste amplía el espectro de resultados de búsqueda, adaptándose a situaciones donde los modelos pueden ser aplicados a varios casos de uso.

Se modificaron las miniaturas de la lista de recursos para utilizar versiones más pequeñas de las imágenes de portada.

- Anteriormente, las miniaturas utilizaban versiones grandes de las imágenes de portada en la lista de recursos. Las actualizamos para usar versiones más pequeñas, alineándolas con otros recursos como aplicaciones, modelos, flujos de trabajo, módulos y conjuntos de datos. También se realizó este cambio en las barras laterales izquierdas.

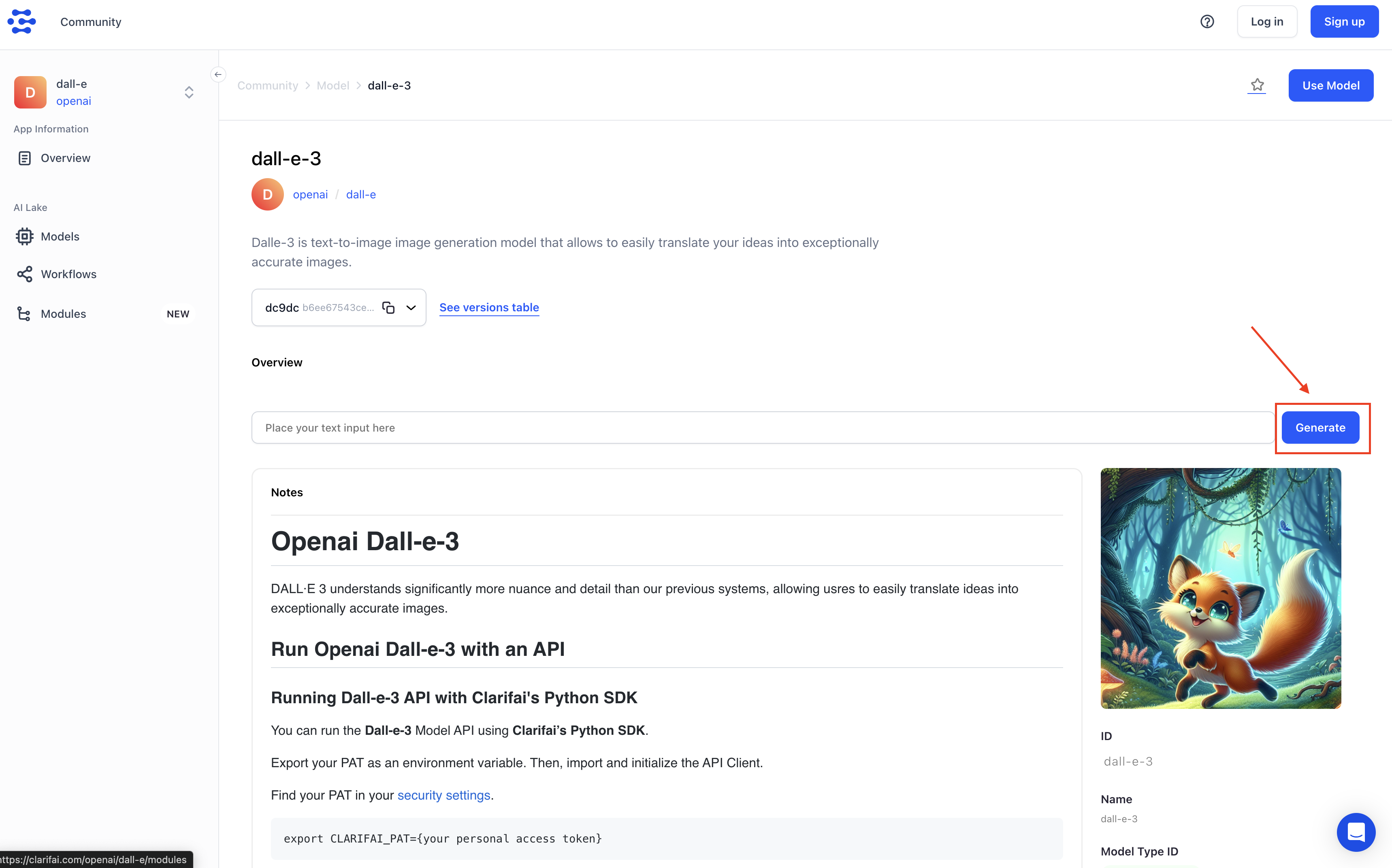

Se realizó una modificación para brindar una experiencia más accesible a los usuarios sin iniciar sesión y que interactúan

Transformación de Texto a Imagen

- Al clicar en el botón "Generar", se abre una ventana emergente para iniciar sesión o registrarse. Esto ayuda a los usuarios que no han iniciado sesión a seguir los pasos de autenticación necesarios, facilitando el uso del modelo de manera más fluida.

Corrección de Duplicación de Usuario en Organizaciones

- Se han implementado medidas para evitar la duplicación involuntaria de usuarios dentro de una organización. Anteriormente, al hacer clic varias veces en el botón "Aceptar" en la página de invitación a la organización, un usuario podía registrarse repetidamente en la misma organización, lo cual generaba múltiples instancias de la misma organización en la interfaz.

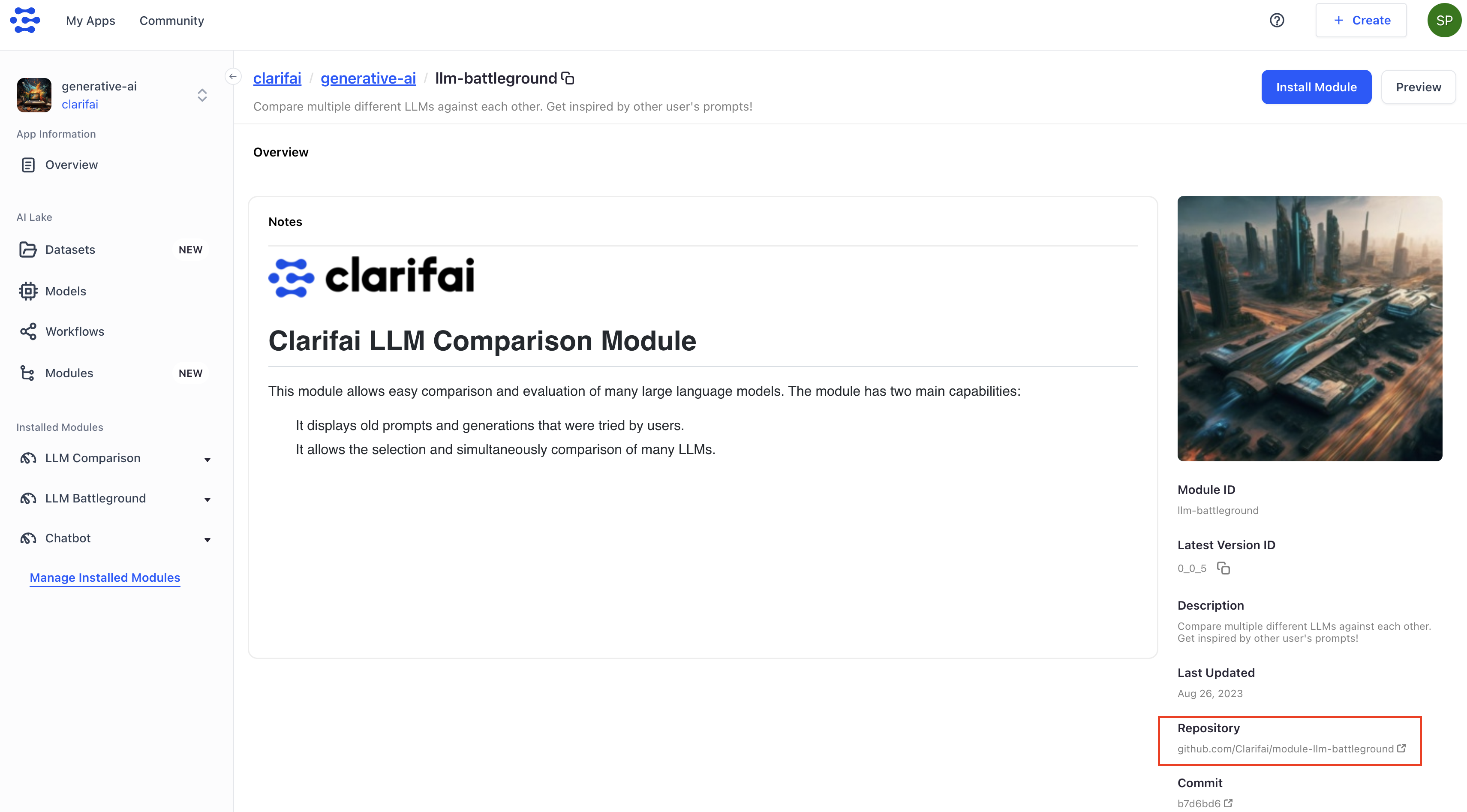

Optimización del Proceso de Instalación de Módulos

- Se ha mejorado el modal para utilizar IDs de aplicaciones, eliminando la dependencia de nombres de aplicaciones obsoletos. Antes, el modal de instalación de un módulo en una aplicación seguía utilizando nombres de aplicaciones obsoletos.

Mejora de la Relevancia del Enlace a GitHub

- Anteriormente, existía un pequeño botón de GitHub en la parte superior de la página de descripción general de cada módulo. Se ha cambiado su ubicación al lado derecho, alineándolo con otros metadatos como la descripción, lo que mejora su visibilidad como enlace clickeable.

¿Nos apoyarás hoy?

Creemos que todos merecen entender el mundo en el que viven. Este conocimiento ayuda a crear mejores ciudadanos, vecinos, amigos y custodios de nuestro planeta. Producir periodismo explicativo y profundamente investigado requiere recursos. Puedes apoyar esta misión haciendo una donación económica a Gelipsis hoy. ¿Te sumarás a nosotros?