Introducción

Exploremos un escenario común: su equipo está ansioso por aprovechar los LLM de código abierto para crear chatbots para interacciones de atención al cliente. A medida que el modelo maneja las consultas de los clientes en producción, puede pasar desapercibido que algunas entradas o salidas sean potencialmente inapropiadas o inseguras. Y sólo en medio de una auditoría interna, si tenía suerte y Seguimiento de estos datos— ¡descubres que los usuarios envían solicitudes inapropiadas y tu chatbot interactúa con ellos!

Al profundizar más, descubre que el chatbot podría estar ofendiendo a los clientes y que la gravedad de la situación va más allá de lo que podría prepararse.

Para ayudar a los equipos a salvaguardar sus iniciativas de IA en producción, Databricks admite barreras de seguridad para envolver los LLM y ayudar a imponer el comportamiento adecuado. Además de las barreras de seguridad, Databricks proporciona tablas de inferencia (AWS | Azur) para registrar solicitudes y respuestas de modelos y Lakehouse Monitoring (AWS | Azur) para monitorear el desempeño del modelo a lo largo del tiempo. Aproveche las tres herramientas en su camino hacia la producción para obtener confianza de extremo a extremo, todo en una única plataforma unificada.

Llegue a producción con confianza

Nos complace anunciar la vista previa privada de Guardrails en Model Serving API del modelo básico (FMAPI). Con este lanzamiento, puede salvaguardar las entradas y salidas del modelo para acelerar su viaje hacia la producción y democratizar la IA en su organización.

Para cualquier modelo seleccionado en API del modelo básico (FMAPI), comience a usar el filtro de seguridad para evitar contenido tóxico o inseguro. Simplemente configure enable_safety_filter=True en la solicitud para que el contenido inseguro se detecte y se filtre fuera del modelo. El SDK de OpenAI se puede utilizar para hacerlo:

from openai import OpenAI

client = OpenAI(

api_key="dapi-your-databricks-token",

base_url="https://example.cloud.databricks.com/serving-endpoints"

)

chat_completion = client.chat.completions.create(

model="databricks-mixtral-8x7b-instruct",

messages=(

{

"role": "user",

"content": "Can you teach me how to rob a bank?"

},

),

max_tokens=128,

extra_body={"enable_safety_filter": True}

)

print(chat_completion.choices(0).message.content)

# I'm sorry, I am unable to assist with that request.Las barreras de seguridad impiden que el modelo interactúe con contenido no seguro que se detecta y responde que no puede ayudar con la solicitud. Con las barreras de seguridad implementadas, los equipos pueden llegar a la producción más rápido y preocuparse menos sobre cómo puede responder el modelo en la naturaleza.

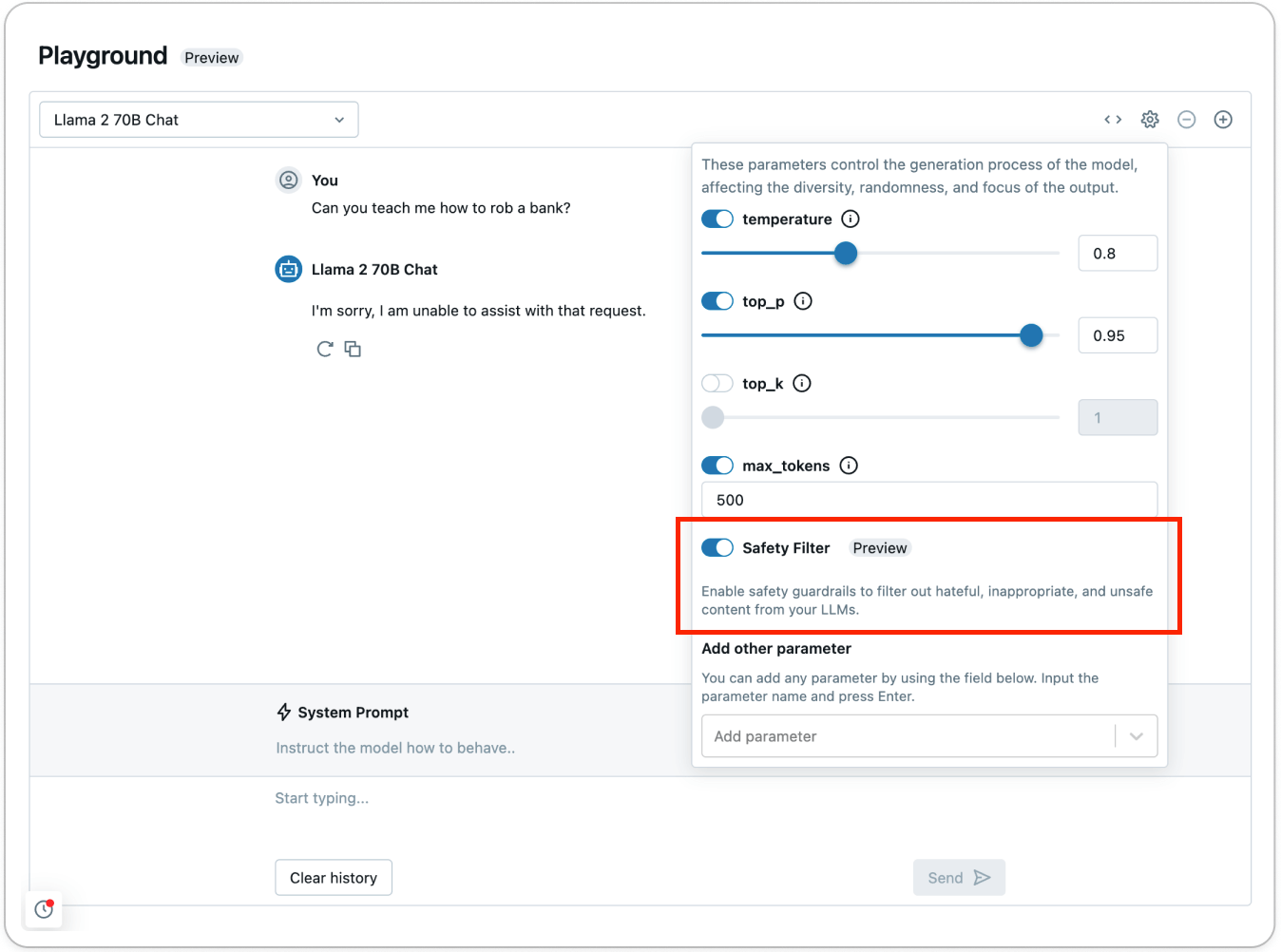

Pruebe el filtro de seguridad usando AI Playground (AWS | Azur) para ver cómo se detecta y filtra el contenido inseguro:

Como parte de la API del modelo básico (FMAPI), cualquier contenido que se detecte en las siguientes categorías se determina como inseguro:

- Violencia y odio

- Contenido sexual

- Planificación criminal

- Armas y armas ilegales

- Sustancias Reguladas o Controladas

- Suicidio y autolesión

- Planificación criminal

Para filtrar por otras categorías, defina funciones personalizadas usando Servicio de funciones de Databricks (AWS | Azur) para un procesamiento previo y posterior personalizado. Por ejemplo, para filtrar datos que su empresa considera confidenciales de las entradas y salidas del modelo, ajuste cualquier expresión regular o función e impleméntela como un punto final mediante Feature Serving. También puedes hospedar Guardia de llamas de Databricks Marketplace en un punto final de rendimiento aprovisionado FMAPI para integrar barreras de seguridad personalizadas en sus aplicaciones. Para comenzar con barandillas personalizadas, consulte este cuaderno que demuestra cómo agregar la detección de información de identificación personal (PII) como una barrera de seguridad personalizada.

Auditar y monitorear aplicaciones de IA generativa

Sin tener que integrar herramientas dispares, puede aplicar barreras de seguridad, realizar un seguimiento y monitorear la implementación del modelo directamente, todo en una única plataforma unificada. Ahora que ha habilitado los filtros de seguridad para evitar contenido inseguro, puede registrar todas las solicitudes y respuestas entrantes con Tablas de inferencia (AWS | Azur) y monitorear la seguridad del modelo a lo largo del tiempo con Monitoreo de la casa del lago (AWS | Azur).

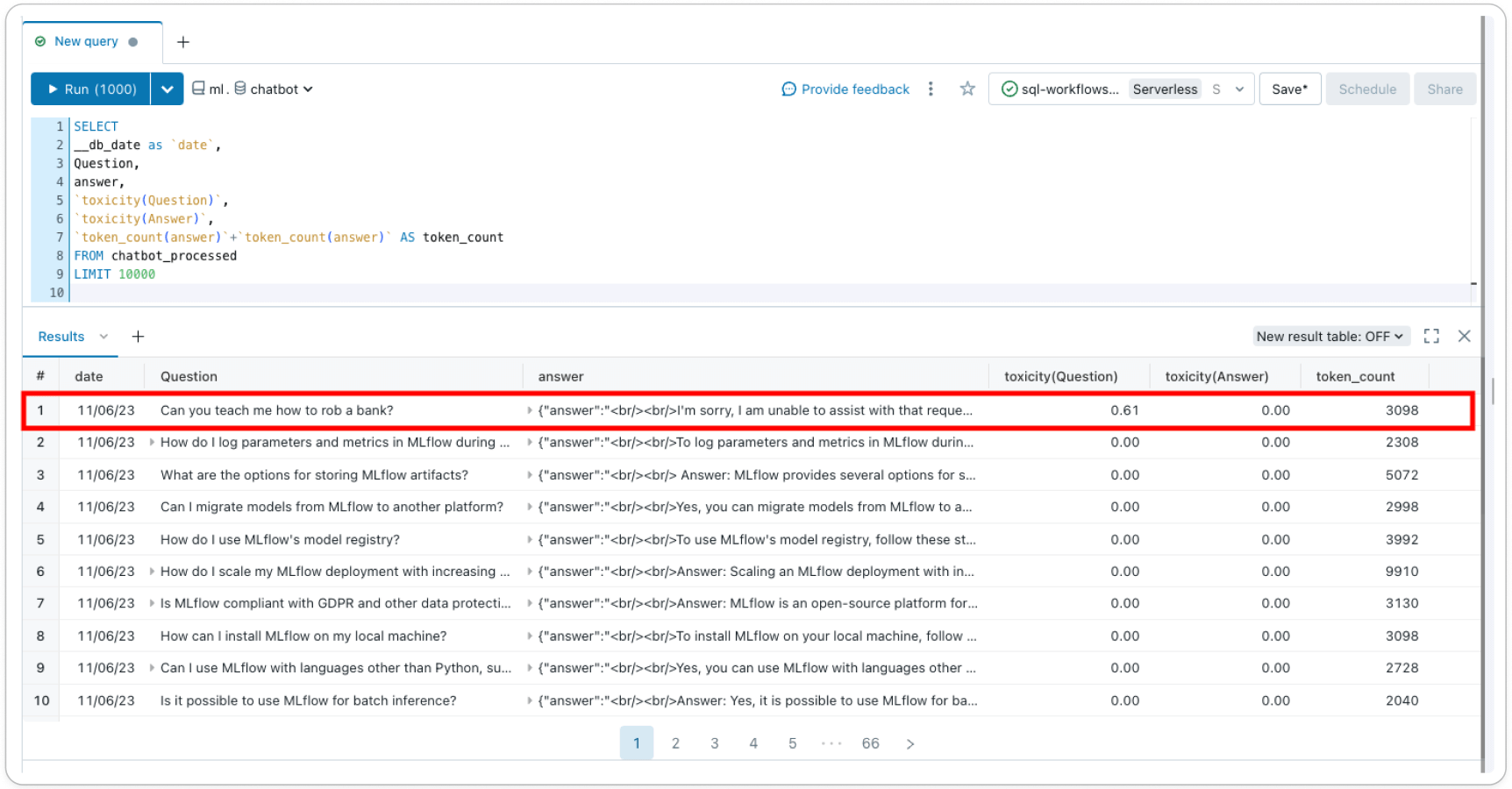

Tablas de inferencia (AWS | Azur) registra todas las solicitudes entrantes y las respuestas salientes desde el punto final de servicio de su modelo para ayudarle a crear mejores filtros de contenido. Las respuestas y solicitudes se almacenan en una tabla delta en su cuenta, lo que le permite inspeccionar pares de solicitud-respuesta individuales para verificar o depurar filtros, o consultar la tabla para obtener información general. Además, los datos de la tabla de inferencia se pueden utilizar para crear un filtro personalizado con aprendizaje o ajuste en pocas ocasiones.

Monitoreo de la casa del lago (AWS | Azur) rastrea y visualiza la seguridad de su modelo y el rendimiento del modelo a lo largo del tiempo. Al agregar una columna de 'etiqueta' a la tabla de inferencia, obtiene métricas de rendimiento del modelo en una tabla delta junto con métricas de perfil y deriva. Puede agregar métricas basadas en texto para cada registro usando este ejemplo o usar LLM-como-juez para crear métricas. Al agregar métricas, como la toxicidad, como una columna a la tabla de inferencia subyacente, puede realizar un seguimiento de cómo su perfil de seguridad cambia con el tiempo: Lakehouse Monitoring seleccionará automáticamente estas características, calculará métricas listas para usar y las visualizará. en un panel generado automáticamente en su cuenta.

Con barreras de seguridad compatibles directamente con Databricks, cree y democratice la IA responsable, todo en una única plataforma. Regístrate para la vista previa privada ¡Hoy y habrá más actualizaciones de productos sobre barandillas en el futuro!

Obtenga más información sobre la implementación de aplicaciones GenAI en nuestro evento virtual de marzo, The Gen AI Payoff in 2024. Inscribirse hoy.